Содержание

Дублированный контент в Вордпресс. Стоит ли беспокоиться?

Дублированный контент. Хорошо это или плохо? Может это вообще не важно? В нете можно найти много разных мнений по этому поводу. Я считаю, что дублированный контент — это большая опасность для блога.

В чем состоит опасность повторяющегося контента?

- Плохой (медленной) индексации. Может новые посты еще более-менее быстро индексируются, то старые, после обновления контента, будут долго ждать своей очереди.

- Выпадения страниц из индекса поисковой системы.

Если робот Googlebot обнаружил чрезвычайно большое количество ссылок на вашем сайте. Это может свидетельствовать о проблеме, связанной со структурой URL-адресов сайта. Возможно, робот Googlebot без необходимости сканирует большое количество различных URL, указывающих на идентичное или похожее содержание, либо сканирует разделы сайта, не требующие сканирования. В результате робот Googlebot может потреблять гораздо больше ресурсов канала передачи данных, чем необходимо. Кроме того, есть вероятность, что он не сможет полностью просканировать все содержание сайта.

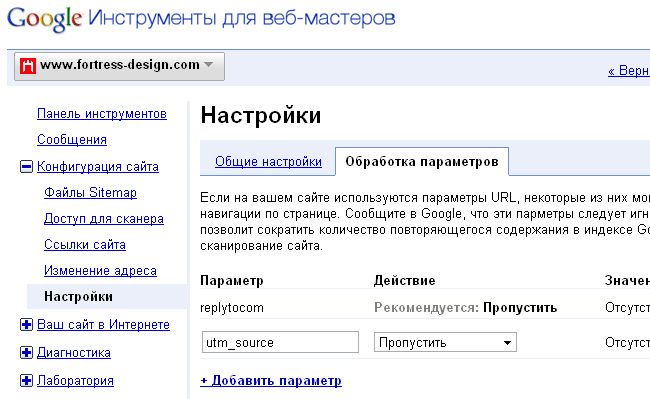

Сегодня обнаружил резкий взрыв «новых» страниц, проиндексированных Яндексом.

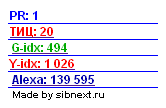

G-idx: 494

Y-idx: 1 030

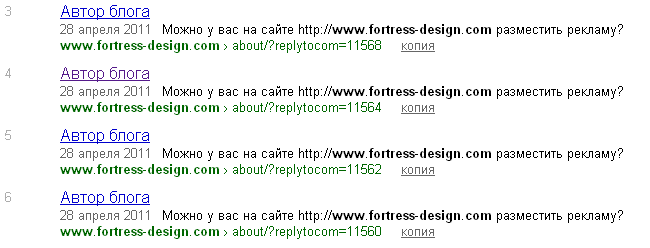

О, это плохо. Такой перепад сигнализирует о дисбалансе индексации. По сравнению с Гуглом, в Яндексе страниц больше, чем в два раза! Пройдя по ссылке, я отсортировал результаты поиска Яндекса по дате. И обнаружил 4 ссылки на одну и ту же страницу, на которой было добавлено 4 комментария.

Параметр ?replytocom

Параметр ?replytocom используется в блогах, которые позволяют отвечать на комментарии, в данном случае Вордпресс. Когда бы вы кликните на ответ в комментарии, вы увидите ссылку, которая будет иметь такой вид:

//www.fortress-design.com/about/?replytocom=11568Очевидно, что эта ссылка не должна находиться в поисковом индексе. Это та же страница как

//www.fortress-design.com/about/только содержит комментарий и параметр ?replytocom с числовым идентификатором.

То есть при появлении каждого комментария на моем блоге, появлялась новая страница отличающаяся от другой только наличием этого отзыва. Подумать только что будет с блогом, если во время не принять меры! Количество страниц возрастет ровно на столько, сколько комментариев будет к каждому посту! И это в то время, когда работают фильтры Яндекса АГС и когда объявлена война сайтам, которые засоряют индекс поисковых систем.

Не откладывая проблему в долгий ящик, я принялся исследовать этот вопрос, чтобы выяснить синтаксис для формирования правила в robots.txt.

Решение проблемы дублирования контента для Вордпресс

Файл robots.txt

Как избавиться от страниц, дублирующих контент основных страниц? Конечно же, с помощью файла robots.txt. Я раньше писал каким должен быть файл robots.txt для WordPress. Но тогда учел не все нюансы.

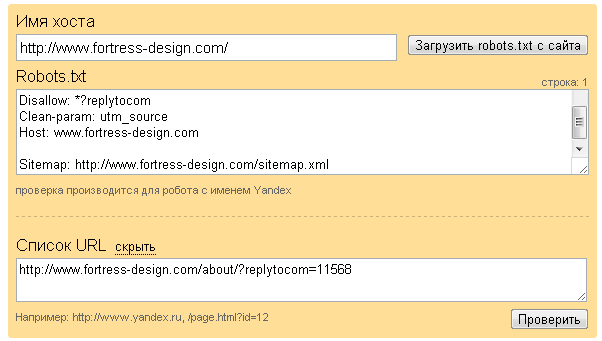

Редактируем файл robots.txt, добавляя правило для запрета индексирования страниц, URL которых содержит параметр ?replytocom.

Disallow: *?replytocomОбновив файл, рекомендую сразу же проверить его с помощью

анализа robots.txt (//webmaster.yandex.ua/robots.xml).

И тут же получить результаты проверки:

Некоторые, чтобы ускорить процесс удаления страниц с дублированным контентом, используют специальную форму удаления URL (//webmaster.yandex.ua/delurl.xml). Для удаления необходимо, чтобы индексирование страницы было запрещено в файле robots.txt.

Я руками удалил только 4 страницы.

Плагин для WordPress

Для тех, кто не хочет возиться с редактирования файла robots.txt (или не знает как), есть еще один вариант. Можно просто установить плагин, который я обнаружил, для перенаправления ботов на правильный URL. Он называется Replytcom Redirector (//wordpress.org/extend/plugins/replytocom-redirector/installation/).

Просто скачиваете, устанавливаете и активируете в меню плагинов WordPress. Ничего настраивать не нужно.

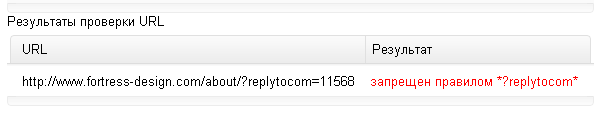

Гугл-инструменты для веб-мастеров

Если на вашем сайте используются параметры URL, которые не нужны для навигации, укажите в панели управления Инструментов для веб-мастеров, что эти параметры следует игнорировать, так как это позволит сократить количество повторяющегося содержания в индексе Google и упростит сканирование сайта.

Кстати, этот параметр replytocom, Гугл добавил сам. Респект ему!

В заключение

Я еще раз убедился в том, что за блогом надо следить и периодически (один или два раза в месяц) проводить SEO-аудит. Таким образом, вы можете своевременно выявить небольшие проблемы, которые могут обернуться серьезной проблемой в будущем.

P.P.S. 4 мая индексация Яндексом была близка к истинному значению. Но положительный результат от правильного файла robots.txt очевиден: из поисковой базы Яндекса удалено 1026-478 = 548 дублей. Но Гугл где-то нашел 154 страницы. С этим надо разбираться.

В действительности, карта сайта насчитывает 400 страниц вместе с главной. Она у меня создается автоматически специальным плагином для Вордпресса.

Спасибо! По делу, а я искал в чем причина.

Ой-ой! Я кликнул по вашему нику и перешел на сайт. Блог явно находится под фильтром Яндекса — в индексе только одна страница. В то время как Гугл проиндексировал 585 страниц. Срочно надо спасать блог!

Здравствуйте! Мой сайт был прекрасно проиндексирован, но потом Яндекс резко выбросил его из поиска. Добавила в роботс.тхт строчку, посмотрим на результат. Хотя на мой взгляд, видимых причин для таких строгих санкций нет. А что значит эта строчка: clean-param:utm_source? Обязательна ли она? Спасибо.

Добрый день.

Да, ваш сайт под фильтром. В индексе одна страница. Контент уникальный?

utm_source — с таким параметром добавляются в УРЛ ссылки из Твиттера на запись в блоге.

Я использую видео с Ютуба, а текст к нему, конечно, уникальный, мой. Дело в том, что под таким фильтром оказались 4 моих блога, и я не могу понять причины. Если бы знала, что нужно исправить, то исправила бы. Но Платон Щукин присылает отписки, типа: работайте и будет вам «щасье». На данном блоге я кроме того, что отредактировала роботс, еще закрыла партнерские ссылки в сайдбаре. Вот еще счетчики бы закрыть, но на их сайтах пишут, что нельзя ничего менять в коде счетчика, так что не решаюсь. Что еще можно сделать, ума не приложу. Если что подскажете, буду очень благодарна. Спасибо.

Счетчики конечно не могли стать причиной санкций. А закрыть их от индексации, не меняя кода, очень просто — нужно заключить в тег

noindex. Проверте текст на уникальность.И еще может причиной было изобилие рекламы? Сейчас реально, на вашем сайте рекламы больше чем контента.

Спасибо. Попробую поработать с рекламой. И текст проверю — может скопипастили? Хотя, я ведь здесь пишу совсем немного, только о своих чувствах и ощущениях от песен, которые выкладываю.

Я проверил одну страницу Адвегой — уникальность была 100%. У меня в блоге перечислены сервисы для проверки уникальности, попробуйте Миратулз и Текст.ру.

Спасибо, на Миратулз проверила — тоже 100%, так что дело не в этом. Будем искать. Еще раз спасибо.

Да, значит не за контент. Попробуйте сократить количество рекламы и спросить у Платона в чем проблема?

В том-то и дело, что Платон Щукин все время отвечает одно и тоже. Такое впечатление, что последнее время там автоответчик. Что бы ни спросил — один стандартный ответ: почитайте правила или что-то в этом роде.

Все рекомендуют методично с определенной периодичностью ему писать. Должны ответить. Ну и правила тоже надо прочестсь. Может что-то всплывет.

кстати, я одно время напарывался на подобные финты. Бывает, что для обмана кэша браузера добавляется параметр в ссылку со случайным числом. Вот так вот и начинаются проблемы у поисковой системы, которые выливаются в проблемы у сайтовладельцев.

Параметр добавляется чтобы было больше УРЛ с ответом сервера 200? Для искусственного наращивания страниц?

Спасибо. Вроде все прописано в файле robots.txt, а с индексацией яндекса проблемы. Блогу полгода, а в поиске всего 3 страницы, хотя загружено 190 с лишним. Попробую запретить ?replytocom.

Гугл индексирует отлично.

А реально сколько статей написано?

Похоже у вас проблемы с уникальностью контента.

Здравствуйте!

Та же проблема — Яндекс видел в 2 раза больше Гугла, потом сбросил до 4 страниц, потом до нуля.

Долгая переписка, сайт почистил (убрал всю рекламу, убрал несколько платных статей с главной, убрал все виджеты — с повтором статей), почистил код (убрал пробелы), убавил количество меток. Контент весь уникальный (было несколько небольших цитат — убрал)

Недавно ответил от Яндекса «не робот» — страницы появились (пока 2), прошло недели две после моей чистки — может быть еще рано видеть результат..?

Не пойдет дело — хочу заменить шаблон.

Как Вы считаете — поставить плагин Replytcom Redirector сейчас — есть смысл?

Да, печально, всё это. Сайт зафильтрован. Если причиной санкций стал дублированный контент, то достаточно в robots.txt, прописать строку

Disallow: *?replytocom

и дождаться переиндексации. Зачем вам ставить плагин?

Вместе с тем не переставать публиковать новые материалы и если есть бюджет, то закупать ссылки на них.

Спасибо! Попробую.

Скажите а прописывать в роботе нужно два раза? — не освоил я еще его до конца…

здесь — User-agent: *

и здесь — User-agent: Yandex

Звёздочка означает для всех поисковиков, а Yandex — только для Яндекса.

То есть одну и ту же инструкцию дублировать не стоит.

Обозначать определённый поисковик целесообразно использовать, если нужна какая-то отдельная конструкция именно для него.

Спасибо за подсказку, уже прописал в роботе — подождем индексации.

Пожалуйста.

Здравствуйте!

Сменил домен и хостинг, прошло месяца 3-4 и сайт ожил. Сейчас посещаемость до 2000 в сутки.

Disallow: *?replytocom — поставил сразу после Вашего совета и еще отключил «древовидные» комментарии — они давали — replytocom.

Мои предыдущие комментарии у Вас теперь с битой ссылкой — если можно — замените на них адрес сайта на новый.

2000 в сутки — неплохой трафик. Поздравляю.

Если запрещать роботам просматривать теги, категории, архивы… При этом ссылки на них везде по сайту, в том числе и на не запрещённых страницах. Не будит ли PR с основных страниц уходить в некуда?

Считайте ссылка есть, а просматривать её роботу нельзя.

Не уверен на 100%. Но ссылка в ноуфоллоу вес не передаёт, кроме ссылок из Твиттера.

А что есть альтернатива?

Доброго дня, у меня блог вордпрессе, но

?replytocomв ссылках на коменты я не наблюдаю, там другое слово:#comment.Пробывал в robots.txt прописать его, так:

Disallow: *#comment, но в Яндекс Вебмастере ничего непоказывает.Дабавив вручную ссылки в Яндекс, выдало результат что урл не принадлежит моему домену