Содержание

Как запретить индексацию сайта

Чтобы закрыть сайт от всех поисковых роботов, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём две строки:

User-agent: * Disallow: /

Если необходимо закрыть сайт только от поискового робота Яндекса, тогда нужно указать его имя:

User-agent: Yandex Disallow: /

Аналогичным образом ставится блокировка для поисковых робота Google:

User-agent: Googlebot Disallow: /

А чтобы закрыть от индексации для всех поисковиков, кроме одного (например, Яндекс):

User-agent: * Disallow: / User agent: Yandex Allow: /

А теперь с разъяснениями

Robots.txt — текстовый файл, расположенный на сайте, который предназначен для роботов поисковых систем. В этом файле вебмастер может указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы по отдельности.

Запрещающая директива

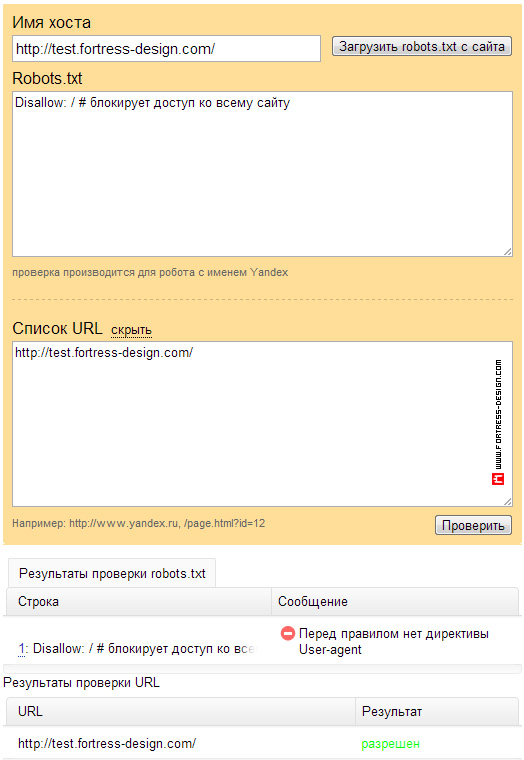

Если вы хотите, чтобы поисковики не индексировали сайт, который находится на этапе разработки, то нужно использовать соответствующую директиву в robots.txt.

<code>Disallow: / # блокирует доступ ко всему сайту</code>

Но это ещё не всё!

Важно! Сама по себе эта директива 'Disallow: /' не способна запретит сканирование вашего сайта. Нужно грамотно оформить весь файл robots.txt.

В самом robots.txt проверяется наличие записей, начинающихся с 'User-agent:', в них ищутся подстроки 'Yandex', либо '*'. В этих инструкциях регистр значения не имеет.

Если обнаружено 'User-agent: Yandex', директивы для 'User-agent: *' не учитываются (потому что есть персональная директива для Яндекса).

Когда доступ к сайту неограничен

Если записи 'User-agent: Yandex' и 'User-agent: *' отсутствуют, считается, что доступ роботу не ограничен.

Также действует правило: если обнаружены директивы для конкретного робота, директивы 'User-agent: Yandex' и 'User-agent: *' не используются.

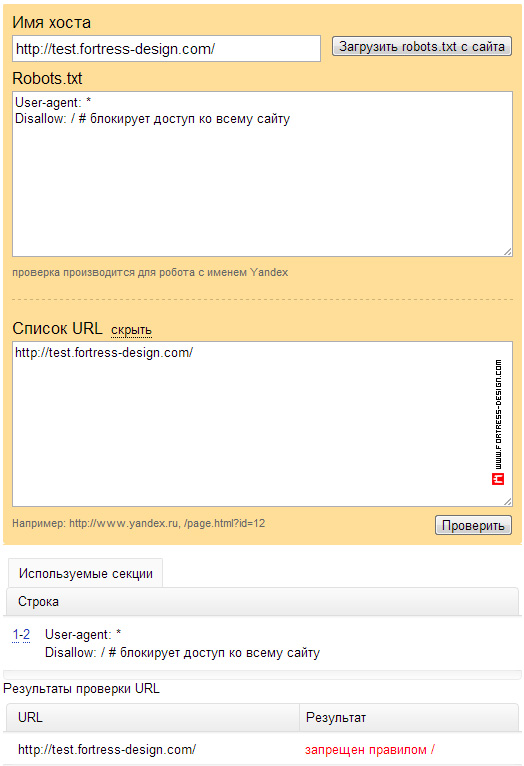

Правильный robots.txt, который блокирует доступ ко всему сайту

Важно! Чтобы запретить доступ робота ко всему сайту, используйте две директивы.

Вот так выглядит правильный robots.txt, запрещающий доступ к сайту для всех роботов сразу:

<code>User-agent: * # директива для всех роботов</code> <code>Disallow: / # блокирует доступ ко всему сайту</code>

Чтобы проверить правильность обработки вашего файла robots.txt, воспользуйтесь анализатором файла robots.txt.

Источник: Яндекс.Вебмастер «Использование директив Disallow и Allow»

Кроме того, чтобы не показывать посетителям незавершенный проект, можно просто закрыть сайт паролем.

Будьте внимательны!

Только не забудьте открыть страницы сайта для индексации по окончании всех работ. Такое часто бывает. Даже у меня был один случай. Спустя год, мне стало интересно как поживает сайт который я сделал одному клиенту. Решил проверить сколько у них страниц в индексе и, о ужас, в индексе ничего. Я стал выяснять причину и обнаружил, что robots.txt стоит запрет на индексирование. Но клиент этого даже не заметил, так как он весьма скептически относился к продвижению. Ему нужен был сайт в качестве онлайн-каталога.

А вообще, случается такое, что вебмастера продвигают контент, который закрыт в Robots.txt. Обязательно проверьте наличие продвигаемых страниц в индексе ПС. Постранично это можно сделать в вебмастере Яндекса. А если используете системы автоматизации, например PromoPult, то массовую проверку SEO-параметров продвигаемых URL-ов проводите на втором шаге проекта «Страницы».

Дополнительные материалы: The Ultimate Guide to Hiding Webpages from Indexation

а как закрыть сайт только для яндекса?

Чтобы закрыть сайт от ботов Яндекса, нужно написать всего две строки:

Потом обязательно проверьте свой файл robots.txt специальным .

Подскажите, а как мне закрыть от индексации яшей и гуглом одну определенную страницу на сайте??

писать что-то вроде??

User-agent: *

Disallow: /адрес страницы (и нужно ли указывать слеш или нет?)

В файле robots.txt можно прописывать правила для Яндекса и точно такие написать, указав бот Гугла.

Допустим у нас на сайте есть страница о пользовательском соглашении, которую мы не хотим индексировать и размещена она по адресу:

site.ru/user-agreement/.Чтобы закрыть эту страницу от индексации в robots.txt нужно добавить строку

вида:

Disallow: /user-agreement/т.е. если я всё понял правильно, то для закрытия от робота страницы, например вот этой МойСйт.ru/ssilki.html

мне нужно прописать примерно вот так

User-agent: Yandex

Disallow: /ssilki.html/

Правильно???

Да. Только зачем в конце слэш добавили?

понял без слеша в конце -))

спасибо!

А что значит строка ?

Disallow: /*p=Это закрытие от роботов страниц пейджинга у которых урл содержит p=

делается в целях уменьшения количества дублей одинаковых страниц

Спасибо, Алексей.

А как закрыть от индексации только главную страницу сайта, к примеру domain.com?

Оригинальный вопрос. Такое даже и в голову бы не пришло )) А зачем вам закрывать только главную? Просто интересно, какое практическое применение для этого можно найти?

На собеседовании спросили:) Закрыть нужно только главную динамическую страницу, остальные должны быть проиндексированы. Как это сделать с помощью роботс.тхт?

Чтобы закрыть от индексации только главную страницу сайта, в

robots.txtнеобходимо использовать правилоDisallow: /$, оно запрещает к обходу только главную страницу вашего сайта.Рекомендую вам также воспользоваться инструментом проверки файла

robots.txt: . Непосредственно в инструменте вы можете корректировать указания и проверять, запрещены или разрешены необходимые вам страницы к индексированию.Спасибо большое!

Благодарю за полезную инфу!

А для ботов Гугла — написать Google вместо Yandex?

Или достаточно поставить звездочку «*» и тогда это ВНИМАНИЕ для всех поисковых роботов?

Если напишете ‘

User-agent: Google‘, то нижеследующие директивы будут относиться исключительно к Гуглу, если поставите звездочку — то ко всем остальным.подскажи пожалуйста, возникла проблема заблокировался нужный файл для индексации и таких много…

/bitrix/image_uploader/images/vendor/canon, canon.pdf

что не так в файле и насколько он вообще грамотно составлен?

+ интересует как здесь закрыть полный доступ googlУ

User-agent: *

Allow: /catalog/

Disallow: /bitrix/

Allow: /bitrix/image_uploader/

Allow: /upload/

Disallow: /search/

Allow: /search/map.php

Disallow: /auth/

Disallow: /service-pages/

Disallow: /include/

Disallow: /cgi-bin/

Disallow: /personal/

Disallow: /auth.php

Disallow: /*?print=

Disallow: /*&print=

Disallow: /*register=yes

Disallow: /*forgot_password=yes

Disallow: /*change_password=yes

Disallow: /*login=yes

Disallow: /*logout=yes

Disallow: /*auth=yes

Disallow: /*backurl=*

Disallow: /*back_url=*

Disallow: /*back_url_admin=*

Disallow: /*index.php?set_filter=*

Disallow: /*index.php?sort=*

Disallow: /*index.php?arrFilter*

Disallow: /*?PAGEN

Disallow: /*?count

Disallow: /*?action

Disallow: /access.log

Disallow: /*?set_filter=*

Disallow: /*?q=*