Что значит «Отсутствует сохранённая копия в Яндексе!» и как это влияет на сайт в целом. Во-первых, если вы продаете ссылки со своего сайта, то отсутствие страниц в кэше Яндекса негативно отразится на доходе веб-мастера.

Например, в Сеопульте есть параметр, контролирующий наличие страницы в кэше поисковой системы.

Называется он nic (no index cache) — это означает что у страницы нет «сохраненной копии».

На сегодняшний день в Сеопульте проверяется индекс Яндекса. В перспективе планируют добавить и проверку в Гугле.

Как говорят специалисты Сеопульт обычно это отражает проблему в структуре сайта и приводит к ухудшению позиций. И советуют, в качестве профилактической меры сменить продвигаемую страницу. Это первая возможная причина.

Вторая — может присутствовать метатег robots со значением noarchive. В таком случае как говорят, специалисты Сеопульта, не стоит беспокоиться.

Но меня беспокоило стремительное падение траста.

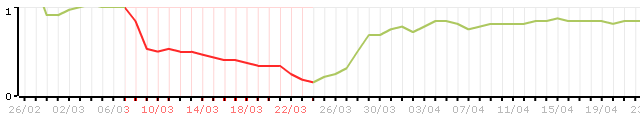

Вот как это выглядит на графике. Долгое время траст был равен девяти, но потом резкое падение.

Я стал искать причину отсутствия сохраненной копии сайта в поисковом индексе. И даже написал в службу поддержки TrustLink.

— Добрый день. Скажите, пожалуйста с чем может быть связано падение траста у моего блога. Параметр XT за последние два апа Яндекса снизился с 9 до 7. Одновременно и снизился доход в Трастлинк.

— Здравствуйте! Этот показатель не является официальным представлением Яндекса, потому причины его паденя нам не известны

— То есть уменьшение количества расставленых ссылок сеопультом с этим не связано. А по какой причине наблюдается уменьшение дохода?

— При проверке часть страниц, на которых были куплены ссылки, отсутствовала в кэше Яндекса. Ссылки были сняты, потому просел доход.

— А не подскажите почему страницы отсутствуют в кэше Яндекса? В индексе есть, а в кэше нет? Как-то можно повлиять на то, чтобы они оказались в кэше?

— Это уже вопрос к техподдержке Яндекса, часто апдейт кэша происходит немного позже апдейта выдачи/индекса, отсюда выходит такая проблема

— А что ссылка не работает, если страница не находится в кэше? Одного присутствия в индексе не достаточно?

— Да, именно так. Для достижения максимальной эффективности ссылки необходимо наличие страницы в кэше.

Потом я задал вопрос в техподдержку Яндекса.

Добрый день.

Сейчас отсутствует сохранённая копия в Яндексе. Подскажите, пожалуйста в чем причина. Блог работает на Вордпрессе.

Кроме того мой блог имел траст xt = 9. За последние два апдейта траст упал до 7. Я стараюсь улучшать свой блог, а тут два таких негативных момента. С чем это может быть связано и как можно исправить ситуацию?

Адрес сайта: //www.fortress-design.com

Спасибо.

С уважением, Илья.

И продолжал искать причину.

Оказывется, после обновления плагинов, флажок напротив значения noarchive был включен. В результате чего на каждой странице моего блога появилась строка, запрещающая кэширование страницы. Возможно по этой причине я потерял две единицы траста.

Убрав этот тег, выключив флажок в плагине Robots Meta, я убедился в его отсутвии на страницах своего блога.

Add

noarchivemeta tagPrevents archive.org and Google from putting copies of your pages into their archive/cache.to put copies of your pages into their archive/cache.

Будьте внимательны при настройке плагина Robots Meta для Вордпресс!

Узнав о наличии тега, запрещающега кэширование, я написал в суппорт Трастлинка.

— Здоравствуйте. Я уже выяснил причину падения траста и отсутствия копии блога в кэше Яндекса. Видимо при обновлении плагинов Вордпресса на страницах присутствовал тег noarchive. Обнаружив это я немедленно убрав его и сегодня уже траст опять стал 9, поднявшись сразу на 2 единицы

Зря оптимизаторы поснимали свои ссылочки.

— Здравствуйте! Ожидайте восстановление закупки в ближайшее время.

И тут мне приходит ответ из службы поддержки Яндекса.

Здравствуйте!

Дело в том, что на момент последней индексации страниц, в их коде содержался мета-тег noarchive. Это явный запрет на показ сохраненной копии в результатах поиска. Сейчас тег убран, но сохраненная копия не появится пока робот не обновит документы в нашей поисковой базе.

В некоторых случаях, робот может посчитать изменения внесенные на странице незначительными, например, если текст на странице практически не поменялся или изменения касаются только html-разметки. Такие документы не обновляются в нашей поисковой базе, так как внесенные изменения на поиск никак не влияют.

—

С уважением, Платон Щукин

Служба поддержки Яндекса

//help.yandex.ru/

На следующий день я опять проверил свой блог в сервисе //xtool.ru/. И о чудо! Моментальный подъем на 2 единицы!

Вот вам и эксперимент.

Вывод: Яндекс отрицательно относится к тегу, запрещающему кэширование страниц. К таким сайтам он относится с меньшим доверием.

P.S. 25 марта сайт успешно был закэширован Яндексом.

P.P.S. Ниже прилагается финасовый отчет в виде графика доходов в Трастлинке за период с 26 февраля 2011 по 22 мая 2011 года.

По вертикальной оси указан доход в у. е, по горизонтальной дата в формате день/месяц.

Красным отмечен период в который сохранённая копия в Яндексе отсутствовала.

Немного о теге “robots”

Запрет на индексацию может стоять в robots.txt или в теге “robots”. Мета-тег “robots” позволяет указывать роботам, можно ли индексировать данную страницу и ссылки, размещенные на ней. Этот тег указывается на каждой конкретной странице, доступ к которой требуется ограничить.

<meta name=“robots” content=“index,follow”>— страница и ссылки индексируются<meta name=“robots” content=“noindex,follow”>— страница не индексируется, ссылки индексируются<meta name=“robots” content=“index,nofollow”>— страница индексируется, а ссылки не индексируются<meta name=“robots” content=“noindex,nofollow”>— страница и ссылки не индексируется

Куда писать мета-тег “robots”

Мета-тег “robots” размещается в область head HTML-страницы:

<html><head><meta name=“robots” content=“noindex,nofollow”><meta name=“description” content=“Описание страницы”><title>…</title></head><body>

Нужно проверить, нет ли препятствий для индексации с помощью инструмента Анализ robots.txt.

Зря оптимизаторы поснимали свои ссылочки.

Зря оптимизаторы поснимали свои ссылочки.

Добрый день.

У меня тоже схожая проблема, половина страниц без кеша в яндексе, в трастлинке не закупают ссылки.

Интересует реальное значимость этого фактора.

Если можно хотелось бы услышать после нейтрализации этого бага какая у вас была скорость покупки была, ну и какая она была во время этой баги.

На моём сайте тоже тИЦ 20 и режим беззаботный.

Отсутствие сохранённой копии в кэше Яндекса негативно сказывается на заработке веб-мастера на своем сайте. Трастлинк просто не покупает на них ссылки. А если они были поставлены, то оптимизаторы тут же снимают их.

Как только появятся закэшированные страницы, закупка возобновится опять.

Так можете сказать немного своей стастики, сколько у вас сняли ссылок из скольки? Ну и тот же вопрос, закупка остановилась вообще, а после того как попали в кеш, она продолжилась, как примерно скорость раскупки была?

Добавил в конце поста статистику доходов. Все очень наглядно. А у вас как раскупают?

А что за значение по оси ординат, почему 1 — это что 1 р в день доход?

p.s. У меня небольшой ростик пошёл, очень плавный но всё же — рост.

Это в у. е.

Трастлинк очень плавно расставляет ссылки. Скорость для каждого сайта индивидуальна. Так, чтобы не было ссылочного взрыва.

Точь-в-точь у меня так же на сайте было. И все плагин Robots Meta. Не знаю, насколько тег noarchive влияет на индексацию яндексом, но замечал, что и с индексацией проблемы были. Вообще удалил этот плагин, оставил только All in Seo.

Блин, и поблагодарить забыл. Ведь именно благодаря этому посту я нашел этот тег и избавился от него. Спасибо, в благодарность нажал кое-куда под формой ввода комментариев:)

Тег noarchive непосредственно влияет — запрещает кэширование страниц в поисковой системе. Robots Meta я не стал удалять. достточно было правильно установить флажок.

Я уже не помню, зачем я ставил Robots Meta, давно это было. Сейчас сразу прописываю в robots.txt запрет на индексирование определенных папок вордпресса, ставлю All in One Seo, этого мне вполне хватает.

Ну вообще-то плагин Robots Meta http://www.fortress-design.com/plagin-robots-meta-dlya-wordpress/ позволяет настроитьт много-сего полезного: RSS в ноуиндекс, добавление ноуфоллоу тегам и разделам, размещенным на внутренних страницах и так далее.

В FF на верхний блок директа попробуй понажимать. Всплывающее окно вываливается пустое и все. Думаю не айс это ))))

А у меня повыпадали все страницы с индекса (кроме главной), траст упал на 0.5 и XTOOL пишет, что нет сохраненной копии в Яндексе, хотя плагин Robots Meta у меня не стоит и в robots.txt не прописан тег noarchive, не могу понять в чем дело???

Наверное сайт попал под фильтр. А трафик есть? Вернее до этого трафик был?

Трафик был с Яндекса минимальный — 10-12 человек. Если бы был фильтр, то думаю XTOOL показал бы, что под фильтром, написал Платонам в Яндекс, будет печалька, если он попал, ничего противозаконного не делал, в индекс попал 1.5 месяца назад и все время сидел, я только статьи писал и все

Трафик, конечно, мал. А, что уже написали Платону?

Да, уже написал, жду ответа! Дело в том, что я бы и не заметил, последний ап был 13 числа, в вебмастере смотрю, в индексе 57 страниц, вот я и не переживал. А сегодня посмотрел статистику LI, смотрю, что по ключам с Яндекса переходят только на главную страницу, а на более релевантные, внутренние не заходят (хотя раньше именно на них заходили). Захожу в вебмастер, нажимаю на индекс 57 страниц, а реально там только 1. Сразу побежал проверять на АГС в XTOOL, он молчек, только выдал, что Отсутствует сохраненная копия в Яндексе, я начал искать проблему, наткнулся на Ваш сайт, а у Вас совсем другая история, вот и разочаровался.

Ну, если Яндекс ответит, напишите мне.

Илья, здравствуйте!

Меня только что Яндекс выпустил из своих «объятий» — месяца два сайт был под АГС. Не успела порадоваться, обнаружила «Отсутствует сохранённая копия в Яндексе!» Но у меня нет плагина Robots Meta, где мне тогда искать причину? Я плохо разбираюсь в тех. делах. Спасибо!

Здравствуйте, Любовь. А как вы определили, что отсутствует сохраненная копия в Яндексе?

Запрет на индексацию можно поставить в robots.txt или с помощью тега robots. Надо проверить, нет ли препятствий для индексации с помощью анализа robots.txt. Более подробно об этих тегах и где они находятся я дописал в конец поста.

А вот тут Яндекс мне привет прислал вчера, когда из заточения выпустил

А трогать robots.txt я почему-то смертельно боюсь…

А что вам Яндекс написал? Просто на данный момент в индексе всего 2 страницы.

Меня это смущает, что нет письма, но красный фонарь сняли только вчера вечером — я ещё надеюсь…

Ясно. Яндекс не будет писать письмо по своей инициативе. Попробуйте написать им, спросите, почему в индексе всего 2 страницы.

Задайте Ваш вопрос непосредственно из сервиса Яндекс.Вебмастер ( ) с помощью формы «Задать вопрос о сайте службе поддержки». Данная форма доступна на каждой странице с информацией о сайте и по ссылке .

Любопытно узнать каков будет ответ.

Спасибо, Илья, за подсказку! Я бы этого не учла.

Но вот что я думаю…Мне многие говорили, что надо сразу писать Яндексу — спрашивать, возмущаться, ведь полгода он продержит меня под фильтром. А чем возмущаться? Ведь ошибки-то есть…

Но я как-то не успела, мне было некогда (я пишу статьи на заказ) — и вот снят фильтр через 2 месяца. Меня больше обижала расшифровка этого АГС.

Поэтом и думаю: помолчу, подожду…Как вы считаете?

А какой смысл ждать? В первую очередь надо получить ответ от Яндекса. А потом уже решать как поступать дальше.

Я хотела кое-что еще почистить — я знаю свои ошибки, т.к. заказывала анализ специалисту СЕО.

Ну если вы уже знаете, что надо исправить, то в любом случае это надо сделать.

Все не так просто! Ошибки мало знать, надо уметь их исправить, а с этим дел обстоит хуже…

Займусь изучением ваших статей — это мне поможет.

А что там что-то сложное есть?